9. Zasada Maksimum Pontriagina

Poprzedni rozdział 8 dotyczył warunku wystarczającego (sufficient condition) istnienia sterowania optymalnego. Natomiast w tym rozdziale 9 sformułujemy warunek konieczny (necessary condition) dla optymalnego sterowania — zwany zasadą maksimum Pontriagina (Pontryagin Maximum Principle). Zasada ta pozwala wyznaczyć optymalne sterowania i optymalne trajektorie — por. przykłady 7.2, 7.3.

Analogia: Minimum funkcji z więzami (ograniczeniami, constraints).

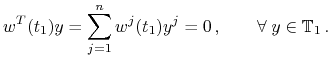

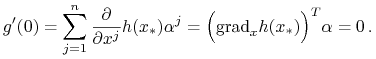

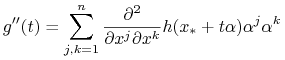

Rozważamy gładkie funkcje

![]() ,

, ![]() ,

, ![]() ,

,

![]() ,

,

gdzie ![]() jest niepustym obszarem w

jest niepustym obszarem w ![]() .

Badamy istnienie minimum funkcji

.

Badamy istnienie minimum funkcji ![]() na hiperpowierzchni (hypersurface)

na hiperpowierzchni (hypersurface)

Jeżeli ![]() jest punktem, w którym

jest punktem, w którym ![]() ma (lokalne) minimum na

hiperpowierzchni

ma (lokalne) minimum na

hiperpowierzchni ![]() , to istnieją liczby (mnożniki Lagrange'a (Lagrange

multipliers))

, to istnieją liczby (mnożniki Lagrange'a (Lagrange

multipliers))

![]() , t.ż.

, t.ż. ![]() ,

, ![]() jest

rozwiązaniem

jest

rozwiązaniem ![]() równań:

równań:

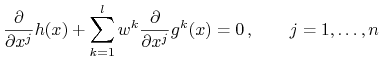

|

czyli

zatem wektor ![]() jest prostopadły do hiperpłaszczyzny stycznej do

hiperpowierzchni

jest prostopadły do hiperpłaszczyzny stycznej do

hiperpowierzchni ![]() w punkcie

w punkcie ![]() , czyli jest normalny do

, czyli jest normalny do ![]() w

w ![]() .

.

W tym rozdziale nie zakładamy żadnych ograniczeń na sterowania, czyli ![]() .

.

Rozpatrujemy najpierw zagadnienie Lagrange'a (L) dla ustalonego punktu końcowego (I) — por.

rozdział 6. Zakładamy, że ![]() jest ciągła względem

jest ciągła względem ![]() oraz

różniczkowalna w sposób ciągły względem

oraz

różniczkowalna w sposób ciągły względem ![]() .

.

Problem 9.1

Mamy zadane punkty ![]() ,

, ![]() . Wśród dopuszczalnych

sterowań

. Wśród dopuszczalnych

sterowań ![]() , o tej własności, że rozwiązanie

, o tej własności, że rozwiązanie ![]() zagadnienia

zagadnienia

przechodzi przez ![]() dla

dla ![]() , tzn.

, tzn. ![]() , znaleźć to, dla którego

, znaleźć to, dla którego

![{\mathfrak{C}}[u]=\int\limits _{{0}}^{{{{t_{1}}}}}\mathfrak{f}^{0}(x(t),u(t))\,\mathrm{d}t\,,](wyklady/tst/mi/mi1193.png) |

przyjmuje najmniejszą wartość.

Definicja 9.1

Sterowanie ![]() , o którym mowa w zagadnieniu 9.1, nazywamy sterowaniem

optymalnym (optimal control), a odpowiednią trajektorię

, o którym mowa w zagadnieniu 9.1, nazywamy sterowaniem

optymalnym (optimal control), a odpowiednią trajektorię ![]() — trajektorią optymalną (optimal trajectory).

— trajektorią optymalną (optimal trajectory).

Zauważmy, że jeżeli sterowanie ![]() ,

, ![]() , prowadzi

, prowadzi ![]() do

do ![]() z wartością

z wartością

![]() , to sterowanie

, to sterowanie ![]() ,

, ![]() także

prowadzi

także

prowadzi ![]() do

do ![]() z wartością

z wartością ![]() . To pozwala przyjąć chwilę

początkową, jako

. To pozwala przyjąć chwilę

początkową, jako ![]() .

.

Każdy kawałek trajektorii optymalnej jest też trajektorią optymalną:

Uwaga 9.1

Jeżeli![]() ,

, ![]() , jest sterowaniem optymalnym prowadzącym

, jest sterowaniem optymalnym prowadzącym ![]() do

do ![]() ,

,

![]() — trajektorią optymalną oraz

— trajektorią optymalną oraz ![]() , to

sterowanie

, to

sterowanie ![]() jest optymalnym sterowaniem prowadzącym

jest optymalnym sterowaniem prowadzącym ![]() do

do

![]() oraz

oraz ![]() jest trajektorią optymalną.

jest trajektorią optymalną.

Dowód: por. [36], str. 22; [31], str. 118.

![]()

Niech wartości ![]() na odcinkach

na odcinkach ![]() ,

, ![]() ,

, ![]() będą oznaczone przez

będą oznaczone przez ![]() ,

, ![]() i

i ![]() , odpowiednio. Wówczas wartość

, odpowiednio. Wówczas wartość ![]() na

odcinku

na

odcinku ![]() , to

, to ![]() . Jeżeli sterowanie

. Jeżeli sterowanie ![]() nie

byłoby optymalne, to istniałoby sterowanie

nie

byłoby optymalne, to istniałoby sterowanie ![]() prowadzące

prowadzące ![]() do

do ![]() z wartością

z wartością ![]() , gdzie

, gdzie ![]() . Zatem istniałoby

sterowanie prowadzące

. Zatem istniałoby

sterowanie prowadzące ![]() do

do ![]() z wartością

z wartością ![]() , co jest sprzeczne z

optymalnością sterowania

, co jest sprzeczne z

optymalnością sterowania ![]() .

.

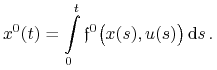

Dla zagadnienia Lagrange'a, zadanego sterowania ![]() i odpowiedzi

i odpowiedzi ![]() określamy

określamy

|

Jeżeli ![]() jest pomyślne, to

jest pomyślne, to ![]() , dla pewnego

, dla pewnego ![]() i odpowiedni koszt to

i odpowiedni koszt to ![]() . Gdy

. Gdy ![]() jest optymalne, to

jest optymalne, to ![]() jest najmniejsze.

jest najmniejsze.

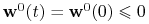

Określamy wektor ![]() –wymiarowy

–wymiarowy ![]() oraz

oraz

Zakładamy, że ![]() oraz

oraz ![]() są ciągłe względem

są ciągłe względem ![]() oraz różniczkowalne w sposób ciągły względem

oraz różniczkowalne w sposób ciągły względem ![]() .

.

Zagadnienie 9.1 można sformułować w następującej, równoważnej postaci:

Problem 9.2

Niech ![]() oraz

oraz ![]() będzie prostą w

będzie prostą w ![]() :

:

gdzie ![]() jest ustalonym punktem. Wśród sterowań

jest ustalonym punktem. Wśród sterowań ![]() , o tej własności,

że rozwiązanie

, o tej własności,

że rozwiązanie ![]() zagadnienia

zagadnienia

| (9.1) |

przecina prostą ![]() , znaleźć to, dla którego punkt

, znaleźć to, dla którego punkt

![]() przecięcia z prostą

przecięcia z prostą ![]() ma najmniejszą współrzędną

ma najmniejszą współrzędną ![]() .

.

Podobnie jak w definicji 9.1:

Definicja 9.2

Sterowanie ![]() , o którym mowa w zagadnieniu 9.2, nazywamy sterowaniem

optymalnym (optimal control), a odpowiednią trajektorię

, o którym mowa w zagadnieniu 9.2, nazywamy sterowaniem

optymalnym (optimal control), a odpowiednią trajektorię ![]() — trajektorią optymalną (optimal trajectory).

— trajektorią optymalną (optimal trajectory).

Wprowadzamy sprzężenie linearyzacji (adjoint to the linearization):

dla zadanego sterowania ![]() i odpowiedzi

i odpowiedzi ![]() rozważamy

rozważamy ![]() –wymiarowe

zagadnienie zlinearyzowane

–wymiarowe

zagadnienie zlinearyzowane

| (9.2) |

Rozwiązanie tego zagadnienia nazywa się rozszerzonym ko-stanem (extended costate; adjoint variable; Lagrange multiplier);

![]() jest macierzą Jacobiego

jest macierzą Jacobiego ![]() względem

względem ![]() ,

,

![\mathbf{f}_{{\mathbf{x}}}\big(x(t),u(t)\big)\,=\left[\frac{\partial\,{\mathbf{f}}^{i}}{\partial\,{\mathbf{x}}^{j}}\right]\,=\,\left[\begin{array}[]{cccc}0&\frac{\partial\, f^{0}}{\partial\, x^{1}}&\ldots&\frac{\partial\, f^{0}}{\partial\, x^{n}}\\

0&\frac{\partial\, f^{1}}{\partial\, x^{1}}&\ldots&\frac{\partial\, f^{1}}{\partial\, x^{n}}\\

.&&&\\

.&&&\\

.&&&\\

0&\frac{\partial\, f^{n}}{\partial\, x^{1}}&\ldots&\frac{\partial\, f^{n}}{\partial\, x^{n}}\\

\end{array}\right]](wyklady/tst/mi/mi1145.png) |

(w pierwszej kolumnie są same zera, gdyż żadna z ![]() nie zależy jawnie od

nie zależy jawnie od ![]() ).

).

Zlinearyzowane równanie opisuje ewolucję wektora stycznego wzdłuż krzywej wyznaczonej przez

rozwiązanie zagadnienia wyjściowego. Sprzężone równanie zlinearyzowane opisuje ewolucję

wektorów prostopadłych — leżących w ![]() -wymiarowej hiperpłaszczyźnie.

-wymiarowej hiperpłaszczyźnie.

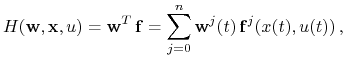

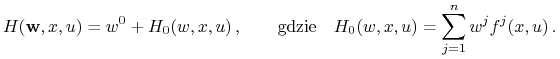

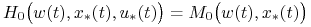

Dla zadanego ![]() , rozważamy ko-stan i rzeczywistą funkcję (Hamiltonian)

, rozważamy ko-stan i rzeczywistą funkcję (Hamiltonian)

|

![]() nie zależy od

nie zależy od ![]() , gdyż

, gdyż ![]() nie zależą od

nie zależą od ![]() :

:

Mamy

![\dot{\mathbf{x}}={\mathrm{grad}}_{{\mathbf{w}}}H({\mathbf{w}},x,u)=\Bigg[\frac{\partial\, H}{\partial\, w^{0}},\frac{\partial\, H}{\partial\, w^{1}},\ldots,\frac{\partial\, H}{\partial\, w^{n}}\Bigg]^{T}\,,\qquad{\rm p.w.}](wyklady/tst/mi/mi1140.png) |

(9.3) |

![{\dot{\mathbf{w}}}=-{\mathrm{grad}}_{{\mathbf{x}}}H({\mathbf{w}},x,u)=-\Bigg[{0},\frac{\partial\, H}{\partial\, x^{1}},\ldots,\frac{\partial\, H}{\partial\, x^{n}}\Bigg]^{T}\,,\qquad{\rm p.w.}\,,](wyklady/tst/mi/mi1173.png) |

(9.4) |

gdzie równanie (9.3), to inny zapis równania (9.1), a równanie (9.4), to

inny zapis równania (9.2). Zatem równanie (9.3), to wyjściowy układ RRZ. W

układzie tym nie pojawia się ko–stan ![]() .

.

Definicja 9.3

Twierdzenie 9.1 (Zasada maksimum Pontriagina (Pontryagin Maximum Principle) dla zagadnienia ustalonego punktu końcowego (fixed–end–point) — (I))

Rozważamy rozszerzone zagadnienie sterowania

z ![]() . Jeżeli

. Jeżeli ![]() jest optymalne na

jest optymalne na ![]() z odpowiedzią

z odpowiedzią

![]() , to istnieje absolutnie ciągła funkcja

, to istnieje absolutnie ciągła funkcja ![]() spełniająca

spełniająca

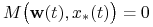

z

-

(i)

p.w. na

p.w. na ![[0,{{t_{1}}}]](wyklady/tst/mi/mi13.png)

-

(ii)

na

na ![[0,{{t_{1}}}]](wyklady/tst/mi/mi13.png)

-

(iii)

oraz

oraz  na

na

![[0,{{t_{1}}}]](wyklady/tst/mi/mi13.png) .

.

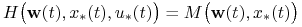

Zasada określa warunek konieczny (necessary condition) sterowania optymalnego:

jeżeli ![]() jest optymalne dla zagadnienia (I), to istnieje para

jest optymalne dla zagadnienia (I), to istnieje para

![]() , t.ż. dla p.k.

, t.ż. dla p.k. ![]()

oraz równość jest osiągana dla ![]() — oczywiście może być również osiągana dla innych

wartości

— oczywiście może być również osiągana dla innych

wartości ![]() .

.

Równość w (i) (bez ,,p.w.”) zachodzi, w każdym punkcie prawostronnej, lub lewostronnej

ciągłości sterowania ![]() — por. [31], Lemma 1, str. 110.

— por. [31], Lemma 1, str. 110.

Uwaga 9.2

Zasada maksimum Pontriagina dla swobodnego punktu końcowego — zagadnienie

(III) — rozdział 6. Jeżeli czas końcowy

![]() jest ustalony, a punkt końcowy

jest ustalony, a punkt końcowy ![]() nie jest zadany, to twierdzenie 9.1

należy uzupełnić o warunek transwersalności (transversality

condition) — por. (9.6):

nie jest zadany, to twierdzenie 9.1

należy uzupełnić o warunek transwersalności (transversality

condition) — por. (9.6):

| (9.5) |

Z twierdzenia 9.1 można wyprowadzić warunek konieczny dla sterowania czaso–optymalnego.

Niech ![]() . Mamy

. Mamy

oraz

|

Wówczas mamy

Niech

Z zależności

otrzymujemy

a zatem

Twierdzenie 9.2 (Zasada maksimum Pontriagina dla sterowania czaso-optymalnego)

Rozważamy zagadnienie

z ![]() . Jeżeli

. Jeżeli ![]() jest czaso–optymalne z odpowiedzią

jest czaso–optymalne z odpowiedzią ![]() , to istnieje absolutnie

ciągła funkcja

, to istnieje absolutnie

ciągła funkcja ![]() spełniająca

spełniająca

z

-

(i)

p.w. na

p.w. na ![[0,{{t_{1}}}]](wyklady/tst/mi/mi13.png)

-

(ii)

na

na ![[0,{{t_{1}}}]](wyklady/tst/mi/mi13.png)

-

(iii)

na

na ![[0,{{t_{1}}}]](wyklady/tst/mi/mi13.png) .

.

Przykład 9.1 (wagon odrzutowy, [36], str. 29–34; [19], str. 36, [31], str. 109, 111)

Por. przyklad 1.2, 2.4, 7.2. Przykład ten jest powtórzeniem

przykładu 7.2 ,,w języku” twierdzenia 9.1. Niech ![]() .

.

![\mathbf{x}=\left[\begin{array}[]{c}x^{0}\\

x^{1}\\

x^{2}\end{array}\right]\,,\qquad{x}=\left[\begin{array}[]{c}x^{1}\\

x^{2}\end{array}\right]\,,\qquad{\mathfrak{C}}[u]=\int\limits _{0}^{{{{t_{1}}}}}1\,{\rm d}t={{t_{1}}}\,,](wyklady/tst/mi/mi1122.png) |

![\dot{x}^{0}=1\,,\qquad\dot{x}^{1}=x^{2}\,,\qquad\dot{x}^{2}=u\,,\qquad\mathbf{f}(x,u)=\left[\begin{array}[]{c}1\\

x^{2}\\

u\end{array}\right]\,,](wyklady/tst/mi/mi1156.png) |

![{\mathbf{f}}_{{\mathbf{x}}}=\left[\begin{array}[]{ccc}0&0&0\\

0&0&1\\

0&0&0\end{array}\right]\,,\qquad{\mathbf{w}}=\left[\begin{array}[]{c}w^{0}\\

w^{1}\\

w^{2}\end{array}\right]\,,](wyklady/tst/mi/mi1178.png) |

Z twierdzenia 9.1: jeżeli ![]() jest czaso–optymalne, to

istnieją liczby

jest czaso–optymalne, to

istnieją liczby ![]() ,

, ![]() , t.ż.

, t.ż.

a to jest osiągane jedynie dla

Funkcja liniowa ![]() jest albo tożsamościowo

jest albo tożsamościowo ![]() , albo zeruje się w co najwyżej

jednym punkcie. Zatem każde czaso–optymalne sterowanie jest p.w. albo tożsamościowo

, albo zeruje się w co najwyżej

jednym punkcie. Zatem każde czaso–optymalne sterowanie jest p.w. albo tożsamościowo ![]() ,

albo bang–bang. Nie może jednak być tożsamościowo

,

albo bang–bang. Nie może jednak być tożsamościowo ![]() , gdyż byłoby wtedy

, gdyż byłoby wtedy

![]() i mielibyśmy

i mielibyśmy ![]() (

(![]() nie może znikać), co by dawało

nie może znikać), co by dawało

![]() , a zatem

, a zatem ![]() , co byłoby sprzeczne z twierdzeniem

9.1 (ii); por. przykład 7.2.

, co byłoby sprzeczne z twierdzeniem

9.1 (ii); por. przykład 7.2.

Rozważmy przypadek, gdy punkt końcowy ![]() nie jest ustalony, lecz należy do zadanego zbioru

nie jest ustalony, lecz należy do zadanego zbioru

![]() , o którym zakładamy, że jest

, o którym zakładamy, że jest ![]() –wymiarową gładką

rozmaitością (manifold; por. [12], str. 64)

w

–wymiarową gładką

rozmaitością (manifold; por. [12], str. 64)

w ![]() ,

, ![]() — zagadnienie (II). Możemy sformułować następujące twierdzenie

— zagadnienie (II). Możemy sformułować następujące twierdzenie

Twierdzenie 9.3 (Zasada maksimum Pontriagina dla zagadnienia dla punktu końcowego z zadanej rozmaitości — (II))

Rozważamy rozszerzone zagadnienie sterowania

z ![]() . Jeżeli

. Jeżeli ![]() jest optymalne na

jest optymalne na ![]() z odpowiedzią

z odpowiedzią ![]() ,

to istnieje absolutnie ciągła funkcja

,

to istnieje absolutnie ciągła funkcja ![]() spełniająca

spełniająca

z

-

(i)

p.w. na

p.w. na ![[0,{{t_{1}}}]](wyklady/tst/mi/mi13.png)

-

(ii)

na

na ![[0,{{t_{1}}}]](wyklady/tst/mi/mi13.png)

-

(iii)

oraz

oraz  na

na

![[0,{{t_{1}}}]](wyklady/tst/mi/mi13.png)

oraz spełniony jest warunek transwersalności (transversality

(transversal ![]() orthogonal to the tangent space))

orthogonal to the tangent space))

-

(iv) wektor

![w({t_{1}})=[w^{1}({t_{1}}),\ldots,w^{n}({t_{1}})]^{T}](wyklady/tst/mi/mi1077.png) jest prostopadły do

przestrzeni stycznej (tangent space)

jest prostopadły do

przestrzeni stycznej (tangent space)  do rozmaitości

do rozmaitości

w punkcie

w punkcie  :

:

(9.6)

Uwaga 9.3

W przypadku zagadnienia swobodnego punktu końcowego — (III) — warunek transwersalności (9.6) przyjmuje postać (9.5):

Przykład 9.2 (wagon odrzutowy, por. przykład 9.1, [36], str. 51-61; [31], str. 125)

Rozważamy układ równań z przykładu 9.1 z ![]() , jednakże

cel określamy jako

, jednakże

cel określamy jako

czyli jesteśmy zainteresowani osiągnięciem położenia ![]() z dowolną prędkością

z dowolną prędkością

![]() .

.

Wektor styczny (w dowolnym punkcie ![]() ) do

) do ![]() ma postać

ma postać

gdzie ![]() . Warunek transwersalności przyjmuje więc postać

. Warunek transwersalności przyjmuje więc postać

| (9.7) |

skąd ![]() . Ponieważ (por. przykład 9.1)

. Ponieważ (por. przykład 9.1)

to z (9.7) wynika, że ![]() na odcinku

na odcinku ![]() nie zmienia znaku.

Zatem każde czaso–optymalne sterowanie jest stałe i równe albo

nie zmienia znaku.

Zatem każde czaso–optymalne sterowanie jest stałe i równe albo ![]() , albo

, albo ![]() ,

bez przełączeń. Zatem przez każdy punkt początkowy

,

bez przełączeń. Zatem przez każdy punkt początkowy ![]() przechodzą tylko dwie

trajektorie, które mogą być optymalne (dla

przechodzą tylko dwie

trajektorie, które mogą być optymalne (dla ![]() i

i ![]() ).

).

Jeżeli ![]() i punkt początkowy leży powyżej dolnej części trajektorii

przechodzącej przez

i punkt początkowy leży powyżej dolnej części trajektorii

przechodzącej przez ![]() , to jedynie trajektoria dla

, to jedynie trajektoria dla ![]() prowadzi do

prowadzi do

![]() . Natomiast, gdy

. Natomiast, gdy ![]() i punkt początkowy leży na, lub poniżej

dolnej części trajektorii przechodzącej przez

i punkt początkowy leży na, lub poniżej

dolnej części trajektorii przechodzącej przez ![]() , to do celu prowadzi zarówno

trajektoria z

, to do celu prowadzi zarówno

trajektoria z ![]() , jak i

, jak i ![]() .

Mamy więc dwie trajektorie podlegające

zasadzie maksimum. Można jednak pokazać (ćwiczenie), że czas dojścia do

.

Mamy więc dwie trajektorie podlegające

zasadzie maksimum. Można jednak pokazać (ćwiczenie), że czas dojścia do

![]() w obu przypadkach jest różny i optymalnym sterowaniem jest

w obu przypadkach jest różny i optymalnym sterowaniem jest

![]() . Analogicznie dla

. Analogicznie dla ![]() optymalnym sterowaniem jest

optymalnym sterowaniem jest

![]() . Można więc zsyntetyzować optymalne

sterowanie (synthesize the optimal control) wprowadzając

. Można więc zsyntetyzować optymalne

sterowanie (synthesize the optimal control) wprowadzając

i rozważając układ

otrzymujac wszystkie optymalne trajektorie.

Analogia: Zagadnienie minimum rzeczywistej, gładkiej funkcji ![]() na obszarze

na obszarze

![]() .

.

Warunek konieczny (the necessary condition):

Jeżeli punkt ![]() jest minimum funkcji

jest minimum funkcji ![]() , to

, to

Wprowadzając ![]() , gdzie

, gdzie ![]() ,

, ![]() ,

otrzymujemy

,

otrzymujemy

|

Mamy

|

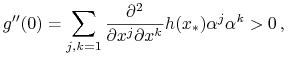

Warunkiem wystarczającym (sufficient condition) minimum jest

|

czyli macierz

jest dodatnio określona.