Zagadnienia

8. Sieci neuronowe

8.1. Sieci neuronowe

8.1.1. Sztuczne sieci neuronowe

8.1.1.1. Inspiracje biologiczna/neurologiczna

-

<+-|alert@+> Podobnie jak symulowane wyżarzanie (SA) i algorytmy genetyczne (GA) sztuczne sieci neuronowe czerpią inspiracje ze zjawisk i procesów zachodzących w otaczającej nas przyrodzie.

-

<+-|alert@+> Techniki wykorzystywane przy tworzeniu sztucznych sieci neuronowych sa inspirowane wiedzą o mechanizmach myślenia zaczerpniętymi z fizjologii, neurologii i badań nad procesem poznawania (cognitive science).

-

<+-|alert@+>W układach nerwowych żywych organizmów stosunkowo proste elementy – neurony – współdziałając są w stanie realizować wysokopoziomowe, złożone funkcje.

-

<+-|alert@+> U podstaw sztucznych sieci neuronowych (ANN) leży idea wykorzystania prostych elementów obliczeniowych – sztucznych neuronów – do tworzenia układów zdolnych rozwiązywać skomplikowane zadania. Siła rozwiązania leży nie w samych elementach obliczeniowych, a w sposobie ich łączenia.

-

<+-|alert@+> Celem jest otrzymanie systemu, który przejawia cechy podobne do układu nerwowego.

-

Dawno, dawno temu – powstały neurony i układ nerwowy.

-

1868 – J.C. Maxwell opisał mechanizm sprzężenia zwrotnego.

-

1942 – N. Wiener formułuje podstawy współczesnej cybernetyki.

-

1943 – W.S. McCulloch i W.H. Pitts przedstawiają ideę działania sztucznego neuronu.

-

1949 – D.O. Hebb w dziele “The Organization of Behavior” opisuje zasadę (regułę Hebba), w oparciu o którą następuje adaptacja w sieciach neuronowych.

-

1957-1962 – Badania F. Rosenblatta nad pierwszymi fizycznymi modelami sieci neuronowych - perceptronami.

-

1960 – G. Widrow i M. Hoff przedstawiają pierwsze modele sieci jednowarstwowych – ADALINE/MADALINE.

-

1969 – M. Minsky i S. Pappert w książce “Perceptrons” poddają miażdzącej krytyce dotychczasowe osiagnięcia perceptroniki. Wykazują słabości i ograniczoność modelu jednowarstwowego. Rezultatem jest zawieszenie na niemal dekadę ok. 70% badań nad ANN.

-

Od 1972 – S. Amari, D. Grossberg, J. Anderson i inni – pierwsze badania nad samoorganizacją w sieciach neuronowych. Wykorzystanie sprzężenia zwrotnego do tworzenia układów naśladujących pamięć asocjacyjną u człowieka.

-

1974 – P. Werbos w swojej pracy doktorskiej podał ideę propagacji wstecznej (backpropagation), dzięki której możliwe stało sie opracowanie efektywnego mechanizmu adaptacji (uczenia się) w sieciach wielowarstwowych.

-

1982 – J. Hopfield przedstawia model sieci rekurencyjnej realizujacej zadania rozpoznawania wzorców i optymalizacji.

-

1986 – D.E. Rumelhart i J.L. McClelland w książce “Parallel Distributed Processing” opisali propagację wsteczną i sformułowali algorytm zmiany wag (regułe delty). Ich praca spowodowała rozpowszechnienie tych idei i w rezultacie lawinowy rozwój badań nad teorią i zastosowaniami ANN.

-

1990 – C. Mead przedstawia pierwsze analogowo-cyfrowe układy elektroniczne wykorzystujące architekture ANN. Pojawiają się poważne zastosowania w przemyśle i obronności.

-

1992 – T. Kohonen przedstawia ideę sieci z samoorganizacją (Self Organising Map – SOM) nazwanej potem jego imieniem. Opisuje także mechanizm uczenia sie kwantyzacji wektorów (Learning Vector Quantisation).

-

Od 1988 prowadzone są intensywne badania podstawowe i stosowane mające na celu podanie lepszych metod konstruowania, uczenia i oceny działania sieci neuronowych. Prowadzone są także badania nad podstawami teoretycznymi działania modelu ANN.

-

Dzień dzisiejszy – sztuczne sieci neuronowe sa uznanym i powszechnie stosowanym narzędziem w wielu działach nauki i techniki.

5cm

-

Masa ok. 1,5 kg - spora wariancja.

-

Objetość ok. 1600 cm3, powierzchnia ok. 2000 cm2 czyli niemal trzykrotnie więcej niż kula o tej samej objętości.

-

Kora - grubość 2-4 mm:

ok.

komórek nerwowych;

komórek nerwowych;ok.

komórek glejowych;

komórek glejowych;ok.

połączeń (średnio

7000 na neuron).

połączeń (średnio

7000 na neuron).

7.5cm

Nie znaleziono korelacji między rozmiarem mózgu a sprawnoscią intelektualną. Jest natomiast związek między rozmiarem kory a zdolnościami mózgu.

8.1.1.2. Perceptron

\columns\column0.4

-

Potencjały odebrane z innych komórek za pomocą dendrytów są zbierane na błonie ciała komórki.

-

Gdy zebrane potencjały przekroczą wartość progową neuron staje sie aktywny i wysyła sygnały elektryczne (elektrochemiczne) przez akson.

-

Inne neurony odbierają sygnał zależnie od przepustowości synaps.

0.6

Rozważmy najprotszy przypadek

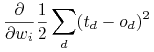

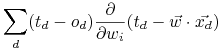

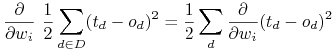

Szukajmy wektora ![]() minimalizujące funkcję błędu:

minimalizujące funkcję błędu:

![E[\vec{w}]\equiv\frac{1}{2}\sum _{{d\in D}}(t_{{d}}-o_{{d}})^{{2}}](wyklady/syd/mi/mi624.png) |

gdzie ![]() jest zbiorem przykładów treningowych.

jest zbiorem przykładów treningowych.

0.6

Gradient

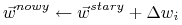

0.45 Alg. gradientu \block

-

Inicjalizujemy wagi neuronu (sieci) np. losowo.

-

Powtarzamy

-

Inicjalizujemy

;

; -

Podajemy kolejny przykład

do sieci i

liczymy wartość

do sieci i

liczymy wartość  ;

; -

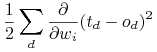

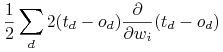

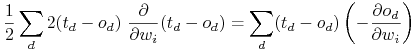

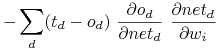

Obliczamy błąd i poprawiamy wagi według reguły uczenia:

gdzie

![\Delta\vec{w}=-\eta\nabla E[\vec{w}]](wyklady/syd/mi/mi594.png)

-

|

||||

|

||||

|

||||

|

||||

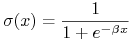

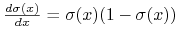

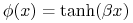

Pierwszym krokiem mającym naprawić niedoskonałości perceptronu, jest wprowadzenie nieliniowych, ciagłych i rózniczkowalnych funkcji aktywacji dla neuronów. Standardowo, stosuje się:

-

Logistyczna funkcje sigmoidalna (unipolarna):

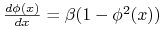

o ważnej własności:

.

. -

Tangens hiperboliczny (bipolarny):

o ważnej własności:

.

.

|

||||

|

||||

|

Wiemy, że

Więc

8.1.1.3. Warstwowe sieci neuronowe dla aproksymacji funkcji

Until satisfied, Do

-

For each training example, Do

-

Input the training example to the network and compute the network outputs \columns\column0.5

0.5

\column

0.5

\column -

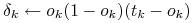

For each output unit

-

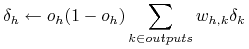

For each hidden unit

-

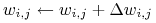

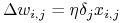

Update each network weight

where

-

8.1.1.4. Inne modele i zastosowania

-

Predykacja: Sieci neuronowe są często wykorzystywane, aby na podstawie pewnych danych wejściowych przewidywała dane wyjściowe. Wazną zaletą jest to, ze sieć może nauczyć się przewidywania sygnałów wyjściowych bez jawnego zdefiniowania związku między danymi wejściowymi a wyjściowymi. Tego typu układy są też często przydatne w zadaniach związanych ze sterowaniem.

-

Klasyfikacja i rozpoznawanie: Zadanie polega na przewidywaniu identyfikatora klasy, do której dany obiekt należy na podstawie wcześniej zaobserwowanych (nauczonych) przykładów..

-

Kojarzenie danych: Sieci neuronowe, dzięki zdolności uczenia się i uogólniania doświadczeń, pozwalają zautomatyzować procesy wnioskowania i pomagają wykrywać istotne powiązania pomiędzy danymi. Sieci neuronowe, dzięki zdolności uczenia się i uogólniania doświadczeń, pozwalają zautomatyzować procesy wnioskowania i pomagają wykrywać istotne powiązania pomiędzy danymi.

-

Analiza danych: Zadanie polega na znalezieniu związków pomiędzy danymi. Realizacja tego zadania przez sieci neuronowe daje nowe możliwości w zakresie prowadzenia analiz ekonomicznych.

-

Filtracja sygnałów Dane gospodarcze pochodzące z różnych źródeł są zakłócone. Klasyczne metody eliminacji “szumów” pozwalają usunąć zakłócenia o charakterze losowym, lecz nie dają podstaw do eliminacji przekłamań systematycznych.

-

Optymalizacja Sieci neuronowe - zwłaszcza sieci Hopfielda - dobrze nadają się do optymalizacji decyzji gospodarczych. Doświadczalnie potwierdzono możliwości sieci do rozwiązywania zadań optymalizacji statycznej i dynamicznej. Szczególnie ciekawe jest zastosowanie sieci do optymalizacji kombinatorycznej i zagadnień (NP)trudnych obliczeniowo, np. TSP.

| Model sieci | Zastosowanie |

| Wielowarstwowa z propagacją wsteczną | Klasyfikacja |

| Predykcja | |

| Sieć rekurencyjna (Hopfielda) | Pamięć skojarzeniowa |

| Sieć konkurencyjna | PCA |

| samo-organizująca sieć (Kohonen) | Analiza skupień |