Zagadnienia

7. Gry ewolucyjne

7.1. Wprowadzenie

Początki teorii gier ewolucyjnych (TGE) sięgają lat 60ych XX wieku. Pierwotnie TGE rozwijała się w oparciu o idee i przykłady wzięte z biologii. Zasadniczym jej elementem bylo spostrzeżenie że biologiczne przystosowanie (fitness) gatunków zależy od interakcji które można opisać językiem teorii gier. Gracze (osobniki, geny) nie zmieniali swych strategii (np. cech w jakie geny wyposażają organizm, przykładowo gresywna, pokojowa), nie musieli wiedziec że graja w grę, a zmiana udziału strategii w populacji brała się z różnego tempa reprodukcji graczy używajacych poszczególonych strategii. W tym kontekście TGE jest związana z darwinowska teoria ewolucji, której jednym z podstawowych postulatów jest założenie że udział procentowy osobników o lepszym przystosowaniu rośnie w populacji.

J. Maynard Smith jako pierwszy w latach 60ych zaproponował wyjaśnianie zachowań zwierząt za pomocą teorii gier. O ile w interakcjach międzyludzkich gracze, agenci, to ludzie, zespoły, instytucje, mający świadomośc uczestniczenia w grze, o tyle w przypadku świata zwierzęcego, ogólniej w biologii, opisywane obiekty nie mają świadomości uczestnictwa w interakcjach które nazywamy teoriogrowymi, nie mają świadomości podejmowania decyzji, i idea opisu takich interakcji za pomocą formalizmu teorii gier miała w owym czasie charakter rewolucyjny. Jedną z inspiracji leżących u źródeł TGE były obserwacje konfliktów w świecie zwierzęcym, np. walk rytualnych, walk o terytorium, o samicę, czy o przewodnictwo w stadzie.

W naukach biologicznych powstały odrębne działy wykozystujące formalizm teorii gier, takie jak biologia ewolucyjna, ekologia ewolucyjna, patrz np. [3]. Rozwijają sie zastosowania TGE w ekonomii, patrz np. [15, 33, 26], w psychologii i w naukach społecznych. W ekonomii gracze to podmioty gospodarcze, wypłaty to zyski, a strategie to np. sposoby działania na rynku. W naukach społecznych stosuje się TGE w szczegolności do opisu, powstawania i utrzymywania się postaw kooperacyjnych i altruistycznych w społeczeństwach (ludzi, zwierzat), do opisu powstawania i ewolucji norm społecznych.

O ile w biologii czestości strategii zależą od temp reprodukcji, a mutacje mają podłoże genetyczne, to w naukach społecznych i w ekonomii zależą od możliwości imitacji jednych graczy przez drugich, oraz od możliwości indywidualnego i grupowego uczenia się (learning), a mutacje to np. eksperymenty, innowacje, przypadkowe błędy czy zachowania idiosynkratyczne. W ekonomii, naukach behawioralnych, stosujemy równania dynamiki imitacji, dynamiki najlepszej odpowiedzi, dynamiki wielokrotnego testowania i inne. Będzie to tematem wykładu XV.

Podstawowym pojęciem klasycznej TG jest równowaga Nasha. TG w zasadzie nie precyzuje czy, i która (gdy jest więcej niż jedna) RN jest grana, osiągana, i jeżeli gracze grają RN, to jak do niej doszli. Teoria Gier Ewolucyjnych (TGE) próbuje odpowiedzieć na te pytania. Podejście ewolucyjne polega na opisie jak zachodzą zmiany składu takich układów, jakie są stany asymptotyczne procesów ewolucyjnych, jaka jest ich stabilność itp.

Równania rozpadu promieniotwórczego i reprodukcji

Niech ![]() oznacza liczbę obiektów pewnego typu w układzie w chwili

oznacza liczbę obiektów pewnego typu w układzie w chwili ![]() . Dla małych przyrostów czasu

. Dla małych przyrostów czasu ![]() postulujemy równanie reprodukcji:

postulujemy równanie reprodukcji:

Dla ![]() otrzymujemy równanie ewolucji

otrzymujemy równanie ewolucji

![]() - stała wzrostu, tempo wzrostu, wyraża sie więc wzorem

- stała wzrostu, tempo wzrostu, wyraża sie więc wzorem

W fizyce cząstek elementarnych rozważa sie analogiczne równanie rozpadu promieniotwórczego. Niech ![]() oznacza masę cząstek elementarnych które nie uległy rozpadowi do czasu

oznacza masę cząstek elementarnych które nie uległy rozpadowi do czasu ![]() . Załóżmy że dla bardzo małych czasów

. Załóżmy że dla bardzo małych czasów ![]()

gdzie ![]() - stała rozpadu promieniotwórczego.

Dla

- stała rozpadu promieniotwórczego.

Dla ![]() otrzymujemy różniczkowe równanie rozpadu promieniotwórczego

otrzymujemy różniczkowe równanie rozpadu promieniotwórczego

7.2. Scenariusz ewolucyjny. Gra Jastrząb-Gołąb

Podstawowy scenariusz ewolucyjny:

Podstawowy scenariusz ewolucyjny jest to eksperyment myślowy, wywód teoretyczny:

1. rozpatrujemy dużą populacja jednakowych graczy

2. każdy posiada jedną, niezmienną strategię

3. zakładamy łączenie losowe w pary, w parach jest jednorazowo rozgrywana 2-osobowa gra symetryczna

4. każdy gracz rodzi potomstwo (reprodukcja aseksualna), wypłata z gry jest to liczebność potomstwa.

5. potomstwo dziedziczy strategię rodzica.

6. wracamy do p. 1.

Uwaga 7.1

Bardziej skomplikowane scenariusze ewolucyjne uwzględniaja np. gry wieloosobowe, zmiany strategii przez graczy, błędy w wyborze optymalnych strategii, wprowadzają nielosowe oddziaływania (selekcja grupowa, dobór krewniaczy, sygnalny itp.)

Gra ewolucyjna jest to gra strategiczna rozgrywana w populacji osobników zgodnie z scenariuszem ewolucyjnym.

Przykład 7.1

Rozważmy dużą populację składajacą się z osobników 2 typów: A i B. Załóżmy dla uproszczenia że osobniki nie

wymierają, liczba osobników każdego typu rośnie w wyniku pewnego procesu, które nazwiemy reprodukcją,

procesem urodzin. Niech będzie w danej chwili ![]()

![]() osobników A i

osobników A i ![]() osobników B,

osobników B,

![]() .

.

Zakładamy że liczba nowych osobników typu A która powstaje w czasie pomiędzy

![]() a

a ![]() jest wprost proporcjonalna do

jest wprost proporcjonalna do ![]() oraz do

oraz do ![]() .

Współczynnik proporcjonalności oznaczamy

.

Współczynnik proporcjonalności oznaczamy ![]() i nazywamy tempem urodzin (birth rate) osobników typu A. Tempo

urodzin

i nazywamy tempem urodzin (birth rate) osobników typu A. Tempo

urodzin ![]() osobników typu A jest więc liczbą nowych osobników typu A powstających

w jednostce czasu

osobników typu A jest więc liczbą nowych osobników typu A powstających

w jednostce czasu ![]() przypadających na jednego ”starego” A, analogicznie

przypadających na jednego ”starego” A, analogicznie ![]() - liczba nowych osobników

typu B na jednego ”starego” B w

- liczba nowych osobników

typu B na jednego ”starego” B w ![]() . Formalnie

. Formalnie ![]() a

zatem w granicy

a

zatem w granicy

|

Wzór ten możemy przyjąć za definicję tempa urodzin dla odpowiednio gładkich funkcji

(w dużych populacjach zamiast liczby osobników danego typu rozważamy ich masę).

Niech ![]() oznacza ułamek (częstość, proporcję, udział) osobników A w populacji w chwili

oznacza ułamek (częstość, proporcję, udział) osobników A w populacji w chwili ![]() .

W czasie

.

W czasie ![]() powstaje

powstaje ![]() osobników typu A i

osobników typu A i ![]() osobników typu B.

Po upływie

osobników typu B.

Po upływie ![]() w populacji będzie więc

w populacji będzie więc ![]() osobników A oraz

osobników A oraz ![]() osobników B. Częstość osobników A będzie równa:

osobników B. Częstość osobników A będzie równa:

Jak łatwo obliczyć,

Otrzymaliśmy intuicyjnie oczywisty

Wniosek 7.1

Częstość graczy A rośnie gdy tempo urodzin osobników A jest większe od tempa urodzin B.

Podstawową rolę w prezentacji podstaw ewolucyjnej teorii gier będzie miala gra Jastrząb–Gołąb.

Gra Jastrząb–Gołąb.

n=2 identyczne osobniki wchodzą w konflikt o pewne dobro, np. terytorium, o wartości ![]() . Niech

. Niech ![]() będzie kosztem walki. Każdy gracz ma do wyboru 2 strategie czyste (akcje): strategia Jastrzębia (J) i strategia Gołębia (G).

Macierz wypłat:

będzie kosztem walki. Każdy gracz ma do wyboru 2 strategie czyste (akcje): strategia Jastrzębia (J) i strategia Gołębia (G).

Macierz wypłat:

| J | G | |

|---|---|---|

| J | ||

| G |

Gra ma 2 ”czyste” RN: ![]() i mieszaną RN

i mieszaną RN ![]()

Rozważamy scenariusz ewolucyjny z grą Jastrząb–Gołąb. Mamy dużą populację składającą się z osobników A=J, i B=G, o częstościach odpowiednio p i 1-p, których losowo

łączymy w pary w każdej jednostce czasu. Każda para rozgrywa jedną grę Jastrząb-Gołąb. Chcemy opisać jak będzie ewoluował skłąd

procentowy Jastrzębi i Gołębi w populacji. Niech ![]() oznacza częstość Jastrzębi w chwili

oznacza częstość Jastrzębi w chwili ![]() .

.

Średnie wypłata osobników grających J i G w chwili ![]() wynoszą odpowiednio

wynoszą odpowiednio

Założenie ze scenariusza ewolucyjnego, że wynikiem gry sa wypłaty w grze są mierzone liczebnością potomstwa, (dziedziczącego strategię rodzica) odpowiada paradygmatowi teorii Darwina: przystosowanie (fitness) jest mierzone liczebnością potomstwa. Teoriogrowym odpowiednikiem przystosowania jest wypłata. Założenie to formalnie formułujemy jako postulat:

Tempa urodzin ![]() są liniowymi funkcjami średnich wypłat osobników J, G:

są liniowymi funkcjami średnich wypłat osobników J, G:

gdzie ![]() jest stałym, niezależnym od interakcji tempem urodzin (baseline fitness), który dodajemy by uniknąć

ujemnych temp urodzin. Zauważmy że w przeciwieństwie np. do rozpadu promieniotwórczego, tempa urodzin są

(przez zależność od składu populacji) zależne od czasu. Otrzymujemy

jest stałym, niezależnym od interakcji tempem urodzin (baseline fitness), który dodajemy by uniknąć

ujemnych temp urodzin. Zauważmy że w przeciwieństwie np. do rozpadu promieniotwórczego, tempa urodzin są

(przez zależność od składu populacji) zależne od czasu. Otrzymujemy

W szczególności, jeżeli ![]() – częstość J w danej chwili jest niższa od

– częstość J w danej chwili jest niższa od ![]() (i różna od zera), to częstość

J rośnie w procesie ewolucyjnym. Analogicznie, jeżeli

(i różna od zera), to częstość

J rośnie w procesie ewolucyjnym. Analogicznie, jeżeli ![]() , to częstość J maleje. dla

, to częstość J maleje. dla ![]() nie zmienia się.

Oznacza to że skład procentowy populacji dąży do

nie zmienia się.

Oznacza to że skład procentowy populacji dąży do ![]() niezależnie od składu początkowego

[o ile

niezależnie od składu początkowego

[o ile ![]() , wpp. populacja składa się cały czas tylko z graczy G lub tylko z graczy J].

Wartość

, wpp. populacja składa się cały czas tylko z graczy G lub tylko z graczy J].

Wartość ![]() można więc nazwać stanem równowagi. Populacja J-G o równowagowym składzie

można więc nazwać stanem równowagi. Populacja J-G o równowagowym składzie ![]() nie zmienia składu

w scenariuszu ewolucyjnym. Odchyłka procentowego udziału każdego typu od składu równowagowego uruchamia

ewolucję do składu równowagowego.

nie zmienia składu

w scenariuszu ewolucyjnym. Odchyłka procentowego udziału każdego typu od składu równowagowego uruchamia

ewolucję do składu równowagowego.

Powyższy model ewolucyjny przestawimy w języku rownań różniczkowych.

Niech ![]() - liczebność układu w

- liczebność układu w ![]() ,

, ![]() –częstość strategii J,

–częstość strategii J, ![]() - tempa urodzin odpowiednio

graczy J, G. W czasie

- tempa urodzin odpowiednio

graczy J, G. W czasie ![]() urodzi się w przybliżeniu

urodzi się w przybliżeniu ![]() Jastrzębi,

Jastrzębi, ![]() Gołębi.

Tempo zmiany

Gołębi.

Tempo zmiany ![]() :

:

| (7.1) |

gdzie ![]() . Dla

. Dla ![]() otrzymujemy równanie różniczkowe ewolucji częstości Jastrzębi

otrzymujemy równanie różniczkowe ewolucji częstości Jastrzębi

| (7.2) |

Punkty ![]() ,

, ![]() i

i ![]() są punktami stałymi (punktami równowagowymi) powyższej dynamiki w omawianym scenariuszu

ewolucyjnym. Pierwszy z nich jest atraktorem, dwa pozostałe to repellery.

są punktami stałymi (punktami równowagowymi) powyższej dynamiki w omawianym scenariuszu

ewolucyjnym. Pierwszy z nich jest atraktorem, dwa pozostałe to repellery.

Uwaga 7.2

Do liczenia średnich wypłat są równoważne scenariusze:

1. Duża populacja graczy: ![]() : częstość grających J,

: częstość grających J, ![]() : częstość G, każdy gra stale swoja strategią

: częstość G, każdy gra stale swoja strategią

2. Duża populacja graczy, każdy gra z prawdopodobieństwem ![]() strategię J, a z prawdopodobieństwem

strategię J, a z prawdopodobieństwem ![]() strategię G.

strategię G.

3. Duża populacja graczy, osobniki grają różne strategie mieszane, ale średnio w każdej chwili czasu

w ![]() wszystkich gier jest grana strategia J, w

wszystkich gier jest grana strategia J, w ![]() gier–strategia G.

gier–strategia G.

7.3. Dynamika replikatorowa

Model dynamiki replikatorowej jest podstawowym i najbardziej znanym różniczkowym modelem TGE.

Rozważamy scenariusz ewolucyjny: GS: ![]()

![]() - liczba strategii czystych,

- liczba strategii czystych,

![]() - liczba (masa) graczy grających strategią

- liczba (masa) graczy grających strategią ![]() (masa podpopulacji

(masa podpopulacji ![]() ),

),

![]() - liczebność populacji (masa całej populacji),

- liczebność populacji (masa całej populacji),

![]() –częstość graczy grających

–częstość graczy grających ![]() , częstość strategii

, częstość strategii ![]() ,

,

![]() - stan populacji w chwili

- stan populacji w chwili ![]() ,

, ![]() - k-ty wersor

w

- k-ty wersor

w ![]() - sympleks jednostkowy. Gracze są nierozróżnialni, więc wersor ma tylko jeden indeks (ogólnie mieliśmy

- sympleks jednostkowy. Gracze są nierozróżnialni, więc wersor ma tylko jeden indeks (ogólnie mieliśmy ![]() - k-ty wersor gracza i-tego).

- k-ty wersor gracza i-tego).

![]() –wypłata strategii

–wypłata strategii ![]() gdy populacja jest w w stanie

gdy populacja jest w w stanie ![]() . Jest to z definicji wartość oczekiwana

zmiennej losowej–wypłaty gracza grającego strategią

. Jest to z definicji wartość oczekiwana

zmiennej losowej–wypłaty gracza grającego strategią ![]() z losowym partnerem z populacji w stanie

z losowym partnerem z populacji w stanie ![]() (i.e.

(i.e. ![]() jest rozkładem tej zmiennej losowej);

jest rozkładem tej zmiennej losowej); ![]() jest prawdopodobieństwem wylosowania gracza grającego strategią

jest prawdopodobieństwem wylosowania gracza grającego strategią

![]() ). Równoważnie można powiedzieć że jest to wypłata gracza grającego

). Równoważnie można powiedzieć że jest to wypłata gracza grającego ![]() z losowo wybranym partnerem grającym strategią mieszaną

z losowo wybranym partnerem grającym strategią mieszaną ![]() .

.

![]() - średnia wypłata w populacji (średnia wypłata losowego gracza).

- średnia wypłata w populacji (średnia wypłata losowego gracza).

Uwaga 7.3

W ogólniejszym przypadku gier k-osobowych ![]() jest wartością oczekiwaną

zmiennej losowej–wypłaty gracza grającego strategią

jest wartością oczekiwaną

zmiennej losowej–wypłaty gracza grającego strategią ![]() z

z ![]() losowo wybranymi partnerami

z populacji w stanie

losowo wybranymi partnerami

z populacji w stanie ![]() .

.

K. Darwin: udział procentowy osobników (czyli strategii) o lepszej adaptacji rośnie w wyniku doboru naturalnego

(”lepsza adaptacja” ![]() wyższe tempo urodzin

wyższe tempo urodzin ![]() wyższa średnia wypłata).

wyższa średnia wypłata).

W rozważanym scenariuszu ewolucyjnym postulat ten formalizujemy w następujący sposób:

Tempo wzrostu liczby osobników grających strategię ![]() w populacji w stanie

w populacji w stanie ![]() jest proporcjonalne (u nas–dla

uproszczenia–równe) do wypłaty strategii

jest proporcjonalne (u nas–dla

uproszczenia–równe) do wypłaty strategii ![]() gdy populacja jest w stanie

gdy populacja jest w stanie ![]() .

.

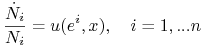

|

Obliczamy

Dzieląc przez ![]() otrzymujemy

otrzymujemy

Równania Dynamiki Replikatorowej (RDR)

Słownie: tempo zmiany ![]() udziału (częstości) i-tej strategii w populacji jest różnicą między wypłatą

strategii

udziału (częstości) i-tej strategii w populacji jest różnicą między wypłatą

strategii ![]() a średnią wypłatą w stanie populacji

a średnią wypłatą w stanie populacji ![]() . Częstości strategii o wypłatach powyżej (poniżej) średniej

rosną (maleją).

. Częstości strategii o wypłatach powyżej (poniżej) średniej

rosną (maleją).

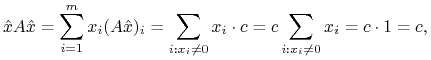

Przypomnijmy że w podstawowym scenariuszu ewolucyjnym gracze grają w symetryczną grę dwuosobową o macierzy wypłat

![]() . Mamy więc

. Mamy więc

| (7.3) |

RDR przyjmuja postać

gdzie ![]() jest macierzą wypłat rozważanej symetrycznej GS.

jest macierzą wypłat rozważanej symetrycznej GS.

Uwaga 7.4

![]()

-

Udział strategii o wyższej wypłacie rośnie, patrz Ćwiczenie 7.1.

-

Sympleks jednostkowy

jest inwariantny względem RDR, patrz Ćwiczenie 7.2.

jest inwariantny względem RDR, patrz Ćwiczenie 7.2. -

Jeżeli do tempa wzrostu

dodamy jednakową dla wszystkich strategii stałą, którą interpretujemy jako różnicę między stałym tempem urodzin i śmierci, to RDR nie ulegną zmianie, patrz Ćwiczenie 7.3.

dodamy jednakową dla wszystkich strategii stałą, którą interpretujemy jako różnicę między stałym tempem urodzin i śmierci, to RDR nie ulegną zmianie, patrz Ćwiczenie 7.3. -

Strategia nieobecna pozostaje nieobecna:

.

. -

Dla

strategii otrzymujemy

strategii otrzymujemy  niezależnych równań różniczkowych z prawymi stronami będącymi wielomianami

których stopień zależy od rzędu gry. Dla gier wieloosobowych stosujemy zamiast (7.3) definicję wypłaty jako

wartości oczekiwanej. Wypłata danej strategii jest wielomianem wyższego stopnia.

Dla gier k-osobowych jest to w ogólności wielomian stopnia

niezależnych równań różniczkowych z prawymi stronami będącymi wielomianami

których stopień zależy od rzędu gry. Dla gier wieloosobowych stosujemy zamiast (7.3) definicję wypłaty jako

wartości oczekiwanej. Wypłata danej strategii jest wielomianem wyższego stopnia.

Dla gier k-osobowych jest to w ogólności wielomian stopnia  .

.

Przykład 7.2

Gra ewolucyjna z dwiema strategiami: ![]() .

Dla gry wieloosobowej z dwiema strategiami mamy

.

Dla gry wieloosobowej z dwiema strategiami mamy

W szczególnym przypadku gry dwuosobowej z macierzą wypłat ![]() otrzymujemy

otrzymujemy

Dla HD: ![]()

Dla PD: ![]()

RDR mają ciekawe własności matematyczne. Udowodnimy interesujące twierdzenie łaczące ”statyczne” pojęcie równowagi Nasha z ”dynamicznym” pojęciem punktu krytycznego (punktu stałego) RDR.

Definicja 7.1

W grach symetrycznych 2-osobowych profil ![]() gracza jest strategią Nasha jeżeli

gracza jest strategią Nasha jeżeli ![]() jest RN.

jest RN.

Twierdzenie 7.1 (Strategia Nasha–punktem stałym RDR)

Jeżeli ![]() jest strategią Nasha w dwuosobowej symetrycznej GS o

jest strategią Nasha w dwuosobowej symetrycznej GS o

![]() macierzy wypłat

macierzy wypłat ![]() , to

, to ![]() jest punktem stałym RDR

jest punktem stałym RDR

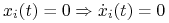

Niech ![]() będzie strategią Nasha. Dla

będzie strategią Nasha. Dla ![]() mamy

mamy

![]() . Dla

. Dla ![]() z Twierdzenia 3.1 (o wypłatach strategii czystych w RN) wynika

istnienie stałej

z Twierdzenia 3.1 (o wypłatach strategii czystych w RN) wynika

istnienie stałej ![]() takiej że

takiej że

Zauważmy że ![]() , a zatem

, a zatem

|

a zatem ![]() .

.

Oto kilka innych interesujących zależności między powyższymi pojęciami. Scisłe sformułowania i dowody tych i innych ciekawych faktów wiążących strategie Nasha i punkty krytyczne RDR można znależć np. w monografiach [11, 39].

Twierdzenie 7.2

![]() Dla gier symetrycznych

Dla gier symetrycznych

Stabilne w sensie Liapunowa (neutralnie stabilne) punkty krytyczne RDR są strategiami Nasha.

Strategie Nasha będące ESS (patrz kolejny podrozdział) są lokalnie asymptotycznie stabilnymi punktami krytycznymi RDR.

Udział strategii ściśle zdominowanej maleje do zera w dynamice replikatorowej.

7.4. Strategia ewolucyjnie stabilna

John Maynard Smith w latach 1970-ych wprowadził pojęcie strategii ewolucyjnie stabilnej (ESS), uzupełniając warunek rownowagi Nasha o dodatkowy warunek stabilności. ESS odgrywa w TGE porównywalną rolę do Równowagi Nasha w klasycznej TG. Nieformalnie ESS jest to taki profil populacji, który jest odporny na inwazję (dostatecznie) małej grupy mutantów o odmiennym fenotypie. Fenotyp to np. cecha budowy ciała (wielkość osobnika, kolor skóry), agresja, altruizm, sygnał wysyłany innym zwierzęciom itp. Fenotypy są dziedziczone.

Uwaga 7.5

Do istotnych osiągnięć ESS należy wytłumaczenie dlaczego na ogół rodzi się mniej więcej tyle samo samców co samic. Okazuje się że strategia rodzenia samców i samic z jednakowym prawdopodobieństwem jest–w odpowiednim formaliźmie teoriogrowym–jedyną strategią ewolucyjnie stabilną.

Definicja (ważna) 7.2 (Maynard Smith, Price, 1973)

W symetrycznej 2–osobowej grze ewolucyjnej strategia ![]() jest ewolucyjnie stabilna

(ESS–Evolutionarily Stable Strategy) jeżeli

jest ewolucyjnie stabilna

(ESS–Evolutionarily Stable Strategy) jeżeli ![]() takiego że dla

takiego że dla ![]() zachodzi

zachodzi

![]() nazywamy barierą inwazyjną.

nazywamy barierą inwazyjną.

Uwaga 7.6

![]()

Twierdzenie 7.3 (Maynard Smith, 1982)

Strategia ![]() jest ESS w populacji graczy łączonych losowo w pary rozgrywające symetryczną grę 2-osobową

jest ESS w populacji graczy łączonych losowo w pary rozgrywające symetryczną grę 2-osobową

![]()

(i) to warunek RN, (ii)–warunek ”stabilności”. Gdyby (ii) nie było spełnione, strategia ![]() mogłaby ”opanować” populację

mogłaby ”opanować” populację ![]() w wyniku neutralnego dryfu.

w wyniku neutralnego dryfu.

Tak więc strategia ![]() jest ewolucyjnie stabilna jeżeli 1.

jest ewolucyjnie stabilna jeżeli 1. ![]() jest najlepszą

odpowiedzią na siebie [a zatem profil

jest najlepszą

odpowiedzią na siebie [a zatem profil ![]() jest RN].

2. jeżeli inna strategia

jest RN].

2. jeżeli inna strategia ![]() jest najlepszą odpowiedzią na

jest najlepszą odpowiedzią na ![]() to

to

![]() , czyli

granie

, czyli

granie ![]() przeciwko

przeciwko ![]() daje wyższą wypłatę niż

daje wyższą wypłatę niż ![]() przeciwko

przeciwko ![]() .

Jeżeli śladowe ilości mutantów grają

.

Jeżeli śladowe ilości mutantów grają ![]() w populacji grającej

w populacji grającej ![]() , to ich

udział w populacji maleje do zera.

, to ich

udział w populacji maleje do zera.

Przepiszmy definicję ESS w postaci

| (7.4) |

![]() :

:

Jeśli ![]() to 7.4 zachodzi dla

to 7.4 zachodzi dla ![]() dostatecznie małych.

dostatecznie małych.

Jeśli ![]() to 7.4 wynika z (ii).

to 7.4 wynika z (ii).

![]()

Ad abs. Niech ![]() nie spełnia (i), i.e.

nie spełnia (i), i.e.

![]() Wtedy

Wtedy

Dla dostatecznie małego ![]() wyrażenie po lewej stronie nierówności (7.4) jest więc ujemne, sprzeczność.

wyrażenie po lewej stronie nierówności (7.4) jest więc ujemne, sprzeczność.

Niech ![]() nie spełnia (ii). Wtedy

nie spełnia (ii). Wtedy ![]()

Wtedy lewa strona (7.4) jest mniejsza lub równa zero, sprzeczność.

∎Natychmiastową konsekwencją tego twierdzenia jest

Wniosek 7.2

Jeżeli ![]() jest ESS to profil

jest ESS to profil ![]() jest (symetryczną) RN.

jest (symetryczną) RN.

Wniosek 7.3

Jeżeli profil ![]() jest ścisłą RN,

to

jest ścisłą RN,

to ![]() jest ESS.

jest ESS.

Przykład 7.3

Pokażemy że ![]() jest ESS w grze HD z macierzą wypłat

jest ESS w grze HD z macierzą wypłat ![]() :

:

| J | G | |

|---|---|---|

| J | ||

| G |

Dla uproszczenia przyjmiemy ![]() , a zatem

, a zatem ![]() . Niech

. Niech ![]() –dowolna inna strategia. Obliczamy

–dowolna inna strategia. Obliczamy

a zatem warunek równowagi (i) jest spełniony. Warunek stabilności sprowadza się do wykazania że

![]() Obliczamy:

Obliczamy:

Uwaga 7.7

Powyższy rezultat wynika też z twierdzenia, które podajemy bez dowodu.

Twierdzenie 7.4

Strategia ![]() jest ESS

jest ESS ![]() dla wszystkich

dla wszystkich ![]() z pewnego jej otoczenia zachodzi nierówność

z pewnego jej otoczenia zachodzi nierówność

Dla gry HD (7.4) i strategii ![]() obliczamy

obliczamy

![]() dla

dla ![]() .

.

Jedną z wad pojęcia ESS jest fakt że nie dla wszystkich klas gier ważnych w teorii i w zastosowaniach ESS istnieje.

Przykład 7.4

W grze Kamień-Papier-Nożyczki, z macierzą wypłat

| K | P | N | |

|---|---|---|---|

| K | 0,0 | -1,1 | 1,-1 |

| P | 1,-1 | 0,0 | -1,1 |

| N | -1,1 | 1,-1 | 0,0 |

jedyna RN jest strategia mieszana ![]() . Jest to więc jedyny kandydat na ESS. Niech

. Jest to więc jedyny kandydat na ESS. Niech ![]() będzie czystą strategią (Kamień). Mamy

będzie czystą strategią (Kamień). Mamy

Warunki te są sprzeczne z częścią ![]() Twierdzenia 7.3, a zatem

Twierdzenia 7.3, a zatem ![]() nie jest ESS, a ponieważ

nie jest ESS, a ponieważ ![]() była jedynym kandydatem, więc ESS nie istnieje.

była jedynym kandydatem, więc ESS nie istnieje.

Ćwiczenie 7.1

Pokaż że jeżeli ![]() , to

, to ![]()

Ćwiczenie 7.2

Pokaż inwariantność sympleksu jednostkowsego względem RDR. Wsk.: wysumuj RDR po wszystkich strategiach i skorzystaj z jednoznaczności rozwiązania odpowiedniego zagadnienia Cauchy'ego.

Ćwiczenie 7.3

Niech tempo urodzin graczy o strategii ![]() wynosi

wynosi ![]() , gdzie

, gdzie ![]() jest stała. Pokaż że RDR nie ulegają zmianie.

jest stała. Pokaż że RDR nie ulegają zmianie.

Ćwiczenie 7.4

RDR dla SD:

Ćwiczenie 7.5

Rozważmy grę

| A | B | |

|---|---|---|

| A | 2,2 | 0,0 |

| B | 0,0 | 0,0 |

w scenariuszu ewolucyjnym. Pokazać że z dwóch strategii Nasha ![]() jest ESS,

jest ESS, ![]() nie.

nie.

Ćwiczenie 7.6

Omówić Twierdzenie 7.1 dla słabego Dylematu Więźnia (napisać RDR, strategie Nasha itp.).